![Аватар сообщества ALPHABET [новости]](/uploads/community/2/1712310220_ff8cf36099c4dff41c9a3ece1045d01c.jpg)

ALPHABET [новости]

НОВОСТИ АКЦИЙ США

Компания Google утверждает, что клиенты могут применять искусственный интеллект в «рискованных» сферах, но только под контролем человека

Компания Google утверждает, что клиенты могут применять искусственный интеллект в «рискованных» сферах, но только под контролем человека. Компания Google внесла изменения в свои правила использования искусственного интеллекта, чтобы уточнить, что клиенты могут применять инструменты генеративного ИИ для принятия автоматизированных решений в областях с высоким уровнем риска, таких как здравоохранение. Однако это возможно только при условии участия человека в процессе. В новой редакции Политики запрещённого использования генеративного ИИ, опубликованной во вторник, компания Google сообщает, что клиенты могут использовать генеративный ИИ для принятия автоматизированных решений, которые могут оказать значительное негативное влияние на права личности. Однако при этом необходимо, чтобы человек контролировал процесс. В контексте ИИ автоматизированные решения — это решения, которые принимаются системой на основе как фактических, так и предполагаемых данных. Например, система может принять автоматизированное решение о выдаче кредита или проверке кандидата на работу. Ранее Google полностью запрещал использование генеративного ИИ для автоматизированного принятия решений в областях с высоким уровнем риска. Однако теперь компания сообщает TechCrunch, что клиенты могут использовать генеративный ИИ для автоматизированного принятия решений даже в областях с высоким уровнем риска, но при условии, что за процессом будет следить человек. «Требование человеческого контроля всегда было частью нашей политики для всех областей с высоким уровнем риска», — заявил представитель Google в ответ на запрос TechCrunch. «Мы пересмотрели некоторые пункты в наших правилах и сделали их более понятными для пользователей, добавив больше примеров». Основные конкуренты Google в области искусственного интеллекта, такие как OpenAI и Anthropic, имеют более строгие правила использования ИИ в автоматизированном принятии решений с высоким уровнем риска. Например, OpenAI запрещает использование своих сервисов для автоматизированного принятия решений, связанных с кредитованием, занятостью, жильём, образованием, социальным скорингом и страхованием. Anthropic позволяет использовать свой ИИ в юриспруденции, страховании, здравоохранении и других областях с высоким уровнем риска для автоматизированного принятия решений, но только под наблюдением «квалифицированного специалиста» и требует от клиентов сообщать о том, что они используют ИИ для этой цели. Использование ИИ для принятия решений, влияющих на отдельных лиц, привлекло внимание регулирующих органов, которые выразили обеспокоенность по поводу потенциального искажения результатов. Исследования показывают, что ИИ, используемый для принятия решений, таких как одобрение заявок на кредиты и ипотеку, может увековечить историческую дискриминацию. Некоммерческая организация Human Rights Watch призвала запретить, в частности, системы «социального скоринга», которые, по мнению организации, могут ограничить доступ людей к социальной поддержке, поставить под угрозу их конфиденциальность и создать предвзятую картину их личности. Согласно Закону об искусственном интеллекте в Европейском союзе, системы ИИ с высоким уровнем риска, включая те, которые принимают индивидуальные решения о кредитовании и трудоустройстве, подвергаются наиболее строгому контролю. Поставщики таких систем должны регистрироваться в базе данных, управлять качеством и рисками, нанимать руководителей-людей и сообщать о происшествиях в соответствующие органы, среди прочих требований. В США, в штате Колорадо, недавно был принят закон, который обязывает разработчиков ИИ раскрывать информацию о «высокорисковых» системах и публиковать заявления, обобщающие возможности и ограничения систем. В то же время в Нью-Йорке работодателям запрещено использовать автоматизированные инструменты для проверки кандидатов на работу, если только инструмент не проходил проверку на предвзятость в течение последнего года. Источник: techcrunch.com

![Аватар сообщества MORGAN STANLEY [новости]](/uploads/community/10/76330125-47dd-4473-81c7-95886ad1fb20.jpg)

![Аватар сообщества NVIDIA [новости]](/uploads/community/1/1712251182_db31c65d08b0368b5ff54be96c90cc17.jpg)

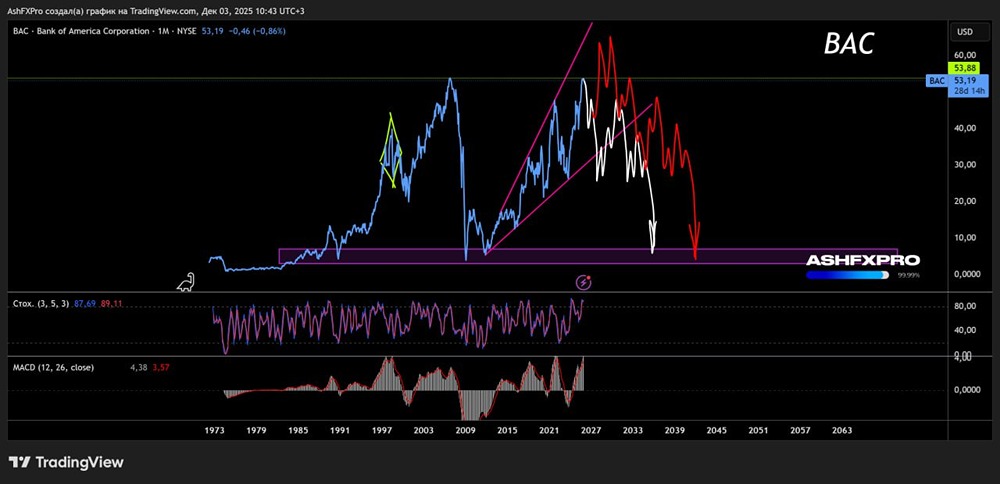

![Аватар сообщества BANK OF AMERICA [BAC] [анализ]](/uploads/community/1/1712239402_1f4a2956544db79cd8b02cc7225fca86.jpg)

![Аватар сообщества UBER [новости]](/uploads/community/3/b58ba830-5907-432c-80e7-6be4b658e702.jpg)

![Аватар сообщества APPLE [новости]](/uploads/community/2/1651f5f9-00e6-46d0-90ec-1b8c7dd0adcd.jpg)

![Аватар сообщества VISA [новости]](/uploads/community/3/86208ff5-1668-4a4d-9f38-1d5a6a2cd64b.jpg)

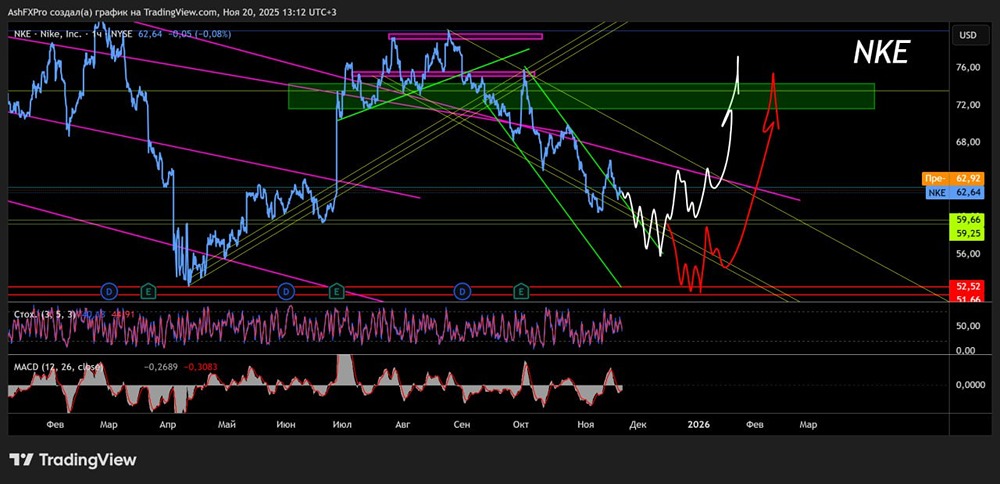

![Аватар сообщества NIKE [NKE] [анализ]](/uploads/community/4/b965ebae-abfe-4d04-8174-0145957b5f11.jpg)

![Аватар сообщества FREEDOM [новости]](/uploads/community/3/6b3aaebc-ce12-47a8-8948-52afc5a5f980.jpg)

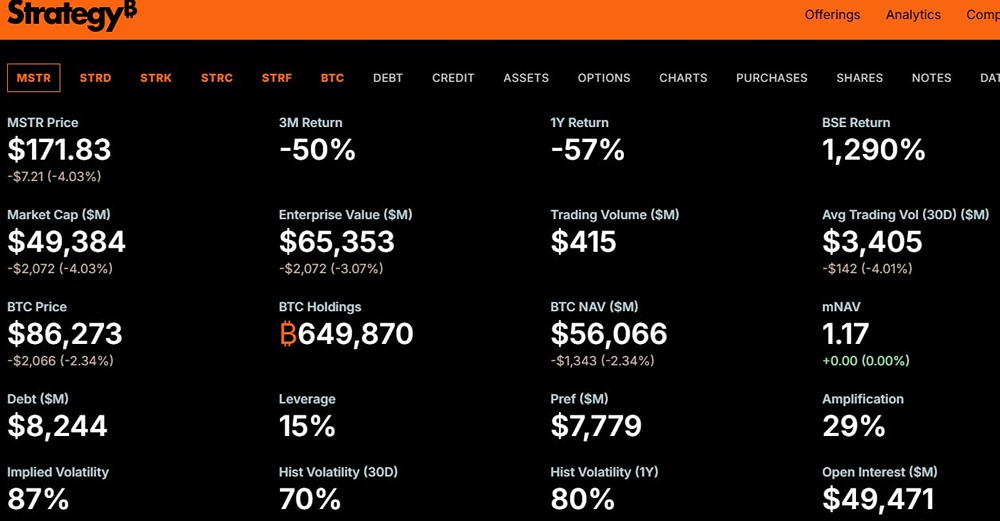

![Аватар сообщества STRATEGY [MSTR] [анализ]](/uploads/community/5/2c11d846-91a8-4462-b768-3da3b48f1049.jpg)

![Аватар сообщества NETFLIX [NFLX] [анализ]](/uploads/community/3/606f7a4e-23d6-499b-a2b4-4b38965318b6.jpg)

![Аватар сообщества STRATEGY [новости]](/uploads/community/5/ed1ed55f-f7cc-43b9-be84-d64f3fb01d12.jpg)

![Аватар сообщества BERKSHIRE HATHAWAY [новости]](/uploads/community/10/7e54b741-708c-42d7-ae4a-6641b2044f74.jpg)

![Аватар сообщества ORACLE [новости]](/uploads/community/3/1712398533_430f34c801de10b6cd641b1ddeba714a.jpg)

![Аватар сообщества FREEDOM [FRHC] [анализ]](/uploads/community/3/135015d0-41bb-43ff-9d41-2a1d18a8a308.jpg)

![Аватар сообщества TESLA [TSLA] [анализ]](/uploads/community/2/f129df75-e246-4a5d-8c20-eaff6c062745.jpg)